前沿 | 8种面部表情实时追踪,你的喜怒哀乐全被AI看穿了

2021-2-4 15:27:04 点击:

与人类一样,AI也学会了“察言观色”

有研究表明,人类在相似的社会环境下表达情感的面部表情几乎是相同的。如果一个人皱眉、嘟嘴、脸色涨红,你一定知道TA是在生气,现在AI同样能够“看穿”这一点。

情感分析一直是AI的重点研究方向,它分为文本识别、语音识别、视觉识别三种主要途径,后者也就是面部表情的分析。

最近这项研究又有了新的进展。在识别生气,愤怒、开心、悲伤等情绪特征的基础上,AI或许能够更进一步追踪面部情绪变化的全过程。

近日,三星人人工智能研究院(Samsung AI)联合伦敦帝国理工学院(Imperial College London)在《自然机器智能》期刊发表了一篇名为《自然状态下人脸连续性效价和唤醒水平估计》的论文。

情感分析一直是AI的重点研究方向,它分为文本识别、语音识别、视觉识别三种主要途径,后者也就是面部表情的分析。

最近这项研究又有了新的进展。在识别生气,愤怒、开心、悲伤等情绪特征的基础上,AI或许能够更进一步追踪面部情绪变化的全过程。

近日,三星人人工智能研究院(Samsung AI)联合伦敦帝国理工学院(Imperial College London)在《自然机器智能》期刊发表了一篇名为《自然状态下人脸连续性效价和唤醒水平估计》的论文。

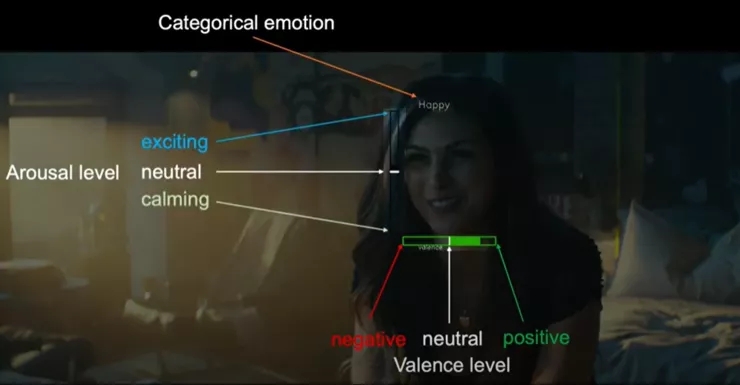

在论文中,研究人员称他们开发了一种基于深度神经网络的AI系统,该系统可以通过分析日常环境下拍摄的图像\视频,高精度地估计人脸面部的情绪效价和情绪唤醒。

这意味着AI系统不仅能够快速、实时且精准地监测面部情绪,同时还能呈现不同情绪所达到的程度。

用深度神经网络识别面部表情

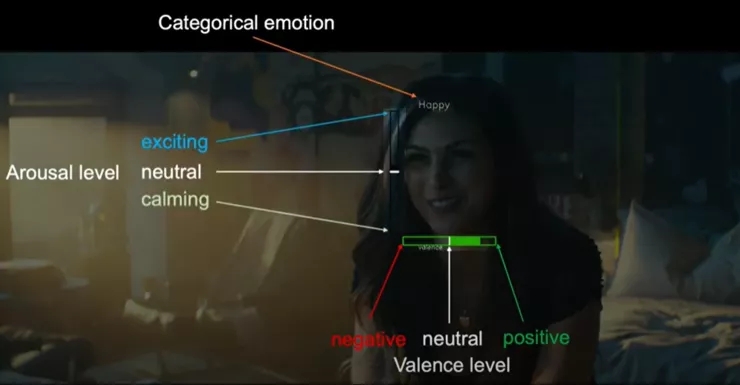

上述提到的情绪效价( Valence )和情绪唤醒(Arousal),是心理学专家用来评估人类情绪的专业术语。

其中,前者描述了一个人对于某事物的感兴趣或排斥的程度。后者是指一个人对外界刺激重新产生反应的程度,比如是微笑,大笑,狂笑,还是歇斯底里的笑。

在论文中,研究人员称他们开发了一种基于深度神经网络的AI系统,该系统可以通过分析日常环境下拍摄的图像\视频,高精度地估计人脸面部的情绪效价和情绪唤醒。

这意味着AI系统不仅能够快速、实时且精准地监测面部情绪,同时还能呈现不同情绪所达到的程度。

用深度神经网络识别面部表情

上述提到的情绪效价( Valence )和情绪唤醒(Arousal),是心理学专家用来评估人类情绪的专业术语。

其中,前者描述了一个人对于某事物的感兴趣或排斥的程度。后者是指一个人对外界刺激重新产生反应的程度,比如是微笑,大笑,狂笑,还是歇斯底里的笑。

在大部分人眼中,通过看脸评估情绪效价和唤醒是很容易的,但对于机器来说却是一项艰难的挑战。

在全世界范围内,众多科研机构和人员都在开发基于深度神经网络的模型,以根据人们的面部表情预测情绪,然而,到目前为止所开发的大多数模型仅能够检测出愤怒、快乐、悲伤等主要情绪状态,而不是人类情感中更微妙的情绪特征。

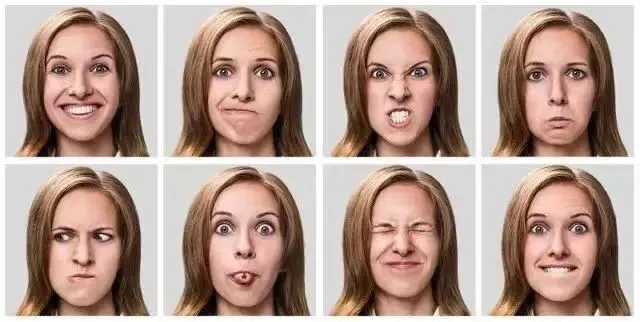

而本次研究提出的深度神经网络模型能够在识别8种基本面部情绪之上,进一步评估情绪的效能水平(积极状态 or 消极状态)以及唤醒水平(激动 or 平静)。

在大部分人眼中,通过看脸评估情绪效价和唤醒是很容易的,但对于机器来说却是一项艰难的挑战。

在全世界范围内,众多科研机构和人员都在开发基于深度神经网络的模型,以根据人们的面部表情预测情绪,然而,到目前为止所开发的大多数模型仅能够检测出愤怒、快乐、悲伤等主要情绪状态,而不是人类情感中更微妙的情绪特征。

而本次研究提出的深度神经网络模型能够在识别8种基本面部情绪之上,进一步评估情绪的效能水平(积极状态 or 消极状态)以及唤醒水平(激动 or 平静)。

如研究人员在论文中写道,“长期以来我们一直致力于研究面部情感分析,一般来说,情感的离散类别有限,无法覆盖人类每天表现出的所有情绪范围,因此,我们把注意力转移到更普遍的情感维度上,即效价和唤醒。”

他们将该模型在三个具有挑战性的数据集上进行了测试,效果如下:

如研究人员在论文中写道,“长期以来我们一直致力于研究面部情感分析,一般来说,情感的离散类别有限,无法覆盖人类每天表现出的所有情绪范围,因此,我们把注意力转移到更普遍的情感维度上,即效价和唤醒。”

他们将该模型在三个具有挑战性的数据集上进行了测试,效果如下:

如我们所见,在连续性状态下,模型能够精准识别面部情绪,并实时反映其情绪所达到的程度,如蓝色条越高代表越愤怒。

黄色条的高度代表悲伤的程度。

如我们所见,在连续性状态下,模型能够精准识别面部情绪,并实时反映其情绪所达到的程度,如蓝色条越高代表越愤怒。

黄色条的高度代表悲伤的程度。

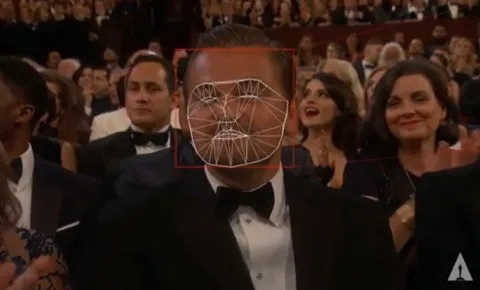

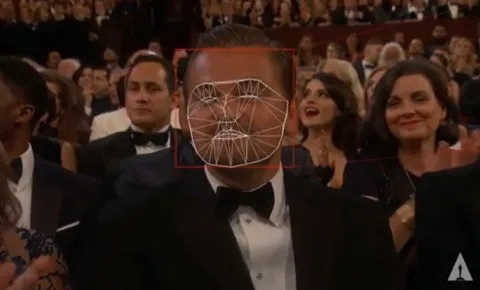

研究人员介绍,该模型主要是通过特定五官来分析面部表情,如一个人的嘴唇、鼻子、眼睛等,这使得它能够把注意力集中在与估计效价和唤醒水平最相关的区域,并实现分析人脸在自然状态下的情绪特征。

另外,该AI模型还能够在8种常见的面部情绪中,给出更精确的监测定位(如右下角)。

研究人员介绍,该模型主要是通过特定五官来分析面部表情,如一个人的嘴唇、鼻子、眼睛等,这使得它能够把注意力集中在与估计效价和唤醒水平最相关的区域,并实现分析人脸在自然状态下的情绪特征。

另外,该AI模型还能够在8种常见的面部情绪中,给出更精确的监测定位(如右下角)。

研究人员称,该模型能够在给定的面部图像上,准确地、连续性地估计情绪效价和唤醒,是因其经过了有注释的图像数据集的训练,这些图像包含了有关效价和唤醒的信息。

同时在算法方面,为了提高模型在任务中的性能,他们使用了离散情绪类别作为辅助标签,以提供额外监督;为了防止在网络训练过程中出现过拟合问题,采用了随机过程、抖动正则化相结合的方法。

当然除了关键算法,构建机器学习系统还需要一个基本要素:合适的数据集。以上Demo的训练数据集为AFEW-VA和SEWA,它们是研究团队专门自建的可用于训练情绪识别的深层神经网络的数据集。

研究人员称,该模型能够在给定的面部图像上,准确地、连续性地估计情绪效价和唤醒,是因其经过了有注释的图像数据集的训练,这些图像包含了有关效价和唤醒的信息。

同时在算法方面,为了提高模型在任务中的性能,他们使用了离散情绪类别作为辅助标签,以提供额外监督;为了防止在网络训练过程中出现过拟合问题,采用了随机过程、抖动正则化相结合的方法。

当然除了关键算法,构建机器学习系统还需要一个基本要素:合适的数据集。以上Demo的训练数据集为AFEW-VA和SEWA,它们是研究团队专门自建的可用于训练情绪识别的深层神经网络的数据集。

研究人员说:“我们创建AFEW-VA数据集,目的是要验证在自然条件下模型的有效性,而不是受控于实验室条件下的有效性。因此该数据集包含的内容均来自真实世界所拍摄的图像和视频。”

在最初的评估中,深度神经网络模型能够在自然条件下拍摄的人脸图像中达到前所未有的准确度,而且在AffectNet和SEWA数据集上进行测试时,它所表现的性能与人工标注基本能够达到一致性。

研究人员说:“我们的神经网络在两个数据集上的表现优于专家注释之间的一致性。”,这意味着如果将神经网络视为另一个人工注释者,那么它与人类注释者之间的一致性至少与其他人类注释者之间的一致性相同,这样的结果是非常显著的。”

更重要的是,除了性能表现良好外,采用深度学习更易于操作和退推广,因为它的预测是基于普通相机拍摄的图像和视频,例如它可以用于市场分析,或创造更具交互性的机器人。

论文的最后,研究人员强调,无论是情绪类型识别的精度度,还是反映不同情绪的变化过程,该AI模型要优于所有现有的方法。

看到这里有同学可能会好奇,AI为什么要达到如此高的情绪识别度?

有哪些潜在应用场景

其实,面部情感分析的目的是让计算机更好地理解人的情绪状态,从而创建更友好的人机交互过程。

在现实环境中,它在智能驾驶、新零售、临床医疗等诸多领域都有着广泛的应用场景,也正是这些领域对AI识别人类情绪的能力提出了更高的要求。

例如在智能驾驶领域,AI对驾驶员的表情识别是提升智能汽车安全性和舒适性的关键因素。比如当系统推荐了一首驾驶员或乘客不喜欢的音乐时,通过分析车内人员的面部表情,系统便可自动“切歌”。

或者在新零售领域,商家可以采用表情识别技术分析顾客情绪,了解他们对不同商品的喜好程度,以此推荐适合的广告,实现精准营销等等。

随着人工智能技术和相关学科的飞速发展,人们对自动化和人机交互的需求日益强烈,表情识别作为计算机理解人类情感的基础,相关研究成果也有了很大的进展,不过,总体而言仍处于实验室探索阶段,距离大规模场景落地还有很长的一段距离。

研究人员说:“我们创建AFEW-VA数据集,目的是要验证在自然条件下模型的有效性,而不是受控于实验室条件下的有效性。因此该数据集包含的内容均来自真实世界所拍摄的图像和视频。”

在最初的评估中,深度神经网络模型能够在自然条件下拍摄的人脸图像中达到前所未有的准确度,而且在AffectNet和SEWA数据集上进行测试时,它所表现的性能与人工标注基本能够达到一致性。

研究人员说:“我们的神经网络在两个数据集上的表现优于专家注释之间的一致性。”,这意味着如果将神经网络视为另一个人工注释者,那么它与人类注释者之间的一致性至少与其他人类注释者之间的一致性相同,这样的结果是非常显著的。”

更重要的是,除了性能表现良好外,采用深度学习更易于操作和退推广,因为它的预测是基于普通相机拍摄的图像和视频,例如它可以用于市场分析,或创造更具交互性的机器人。

论文的最后,研究人员强调,无论是情绪类型识别的精度度,还是反映不同情绪的变化过程,该AI模型要优于所有现有的方法。

看到这里有同学可能会好奇,AI为什么要达到如此高的情绪识别度?

有哪些潜在应用场景

其实,面部情感分析的目的是让计算机更好地理解人的情绪状态,从而创建更友好的人机交互过程。

在现实环境中,它在智能驾驶、新零售、临床医疗等诸多领域都有着广泛的应用场景,也正是这些领域对AI识别人类情绪的能力提出了更高的要求。

例如在智能驾驶领域,AI对驾驶员的表情识别是提升智能汽车安全性和舒适性的关键因素。比如当系统推荐了一首驾驶员或乘客不喜欢的音乐时,通过分析车内人员的面部表情,系统便可自动“切歌”。

或者在新零售领域,商家可以采用表情识别技术分析顾客情绪,了解他们对不同商品的喜好程度,以此推荐适合的广告,实现精准营销等等。

随着人工智能技术和相关学科的飞速发展,人们对自动化和人机交互的需求日益强烈,表情识别作为计算机理解人类情感的基础,相关研究成果也有了很大的进展,不过,总体而言仍处于实验室探索阶段,距离大规模场景落地还有很长的一段距离。

另外,据有关研究表明,人类的面部表情至少有21种,除了高兴、悲伤、愤怒、厌恶等8种常见情绪外,还有13种可别区分的复合表情。那么你觉得未来AI真的能看懂人类复杂的情绪变化吗?

来源:雷锋网