- 合作伙伴

- 政府相关

- 职能网站

Cerebras发布全球首个人类大脑规模的AI解决方案

2021-9-14 10:44:23 点击:

CEREBRAS

来源:IEEE电气电子工程师

Cerebras Systems公司的CS-2人工智能训练计算机包含了世界上最大的单芯片,该公司透露,在计算机上增加新的存储系统可以提高神经网络的规模,它可以扩大至现有最大模型的100倍,可支持超过120万亿参数规模的训练。此外,该公司还提出了两个方案,通过连接多达192个系统和有效处理神经网络中的所谓“稀疏性”来加速训练。Cerberbas的联合创始人兼首席硬件架构师Sean Lie在近日的IEEE Hot Chips 33会议上详细介绍了所涉及的技术。

这些发展来自四种技术的组合:Weight Streaming、MemoryX、SwarmX和Selectable Sparsity。前两种方法将神经网络的规模扩大了两个数量级,CS-2可以训练两个数量级的神经网络,它们改变了计算机的工作方式。

CS-2设计用于快速训练大型神经网络。节省的大部分时间来自这样一个事实:芯片足够大,可以将整个网络(主要由称为权重和激活的参数集组成)保留在芯片上。其他系统会损失时间和电源,因为它们必须不断地将网络的一部分从DRAM加载到芯片上,然后将其存储起来,为下一部分腾出空间。

有了40G的片上SRAM,计算机的处理器WSE2甚至可以容纳当今最大的通用神经网络。但这些网络正在快速增长,仅在过去几年中就增长了1000倍,现在已接近1万亿个参数。因此,即使是晶圆大小的芯片也开始填满。

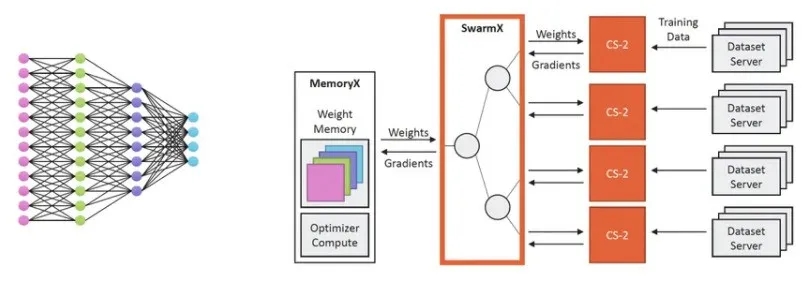

Feldman解释说:“新的方法是保持所有的激活状态,并输入[重量]参数。”该公司为CS-2构建了一个名为MemoryX的硬件插件,该插件将权重存储在DRAM和闪存的混合中,并将其流式传输到WSE2中,在WSE2中,权重与存储在处理器芯片上的激活值进行交互。然后梯度信号被发送到存储器单元以调整权重。该公司表示,通过weight streaming和MemoryX,单个CS-2现在可以训练一个具有多达120万亿个参数的神经网络。

Feldman表示,他和他的联合创始人在2015年成立该公司时就看到了weight streaming的必要性。我们一开始就知道我们需要两种方法,”他说,“然而,我们可能低估了世界将以多快的速度达到非常大的参数大小。”Cerebras在2019年初开始为weight streaming增加工程资源。

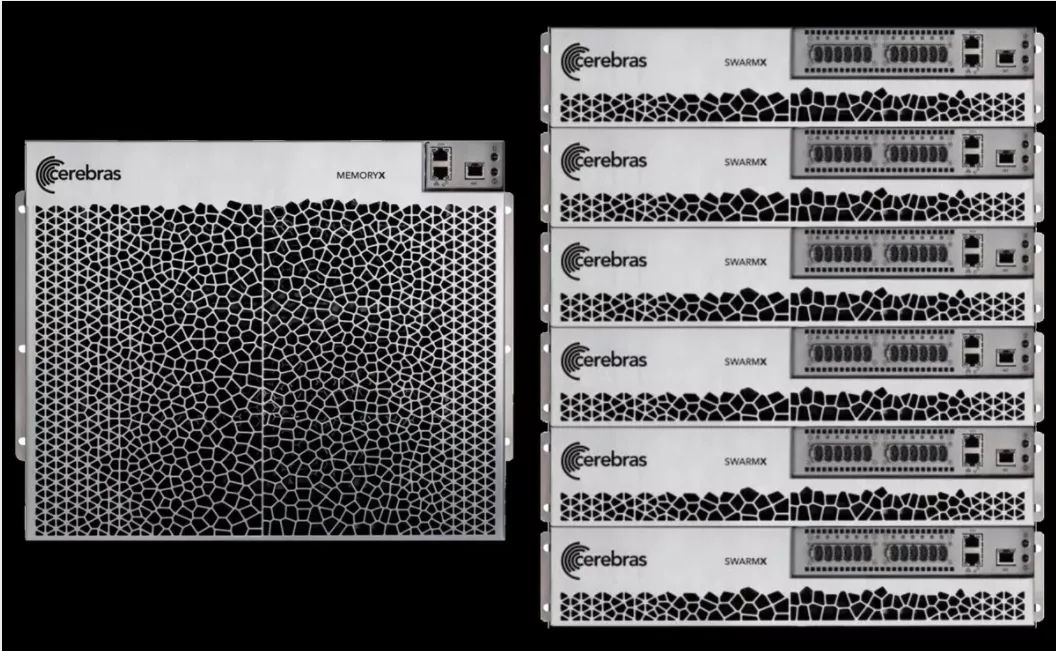

Cerebras的MemoryX一种内存扩展技术,为WSE-2提供高达2.4PB的片外高性能存储,能保持媲美片上的性能。借助MemoryX,CS-2可以支持高达120万亿参数的模型。

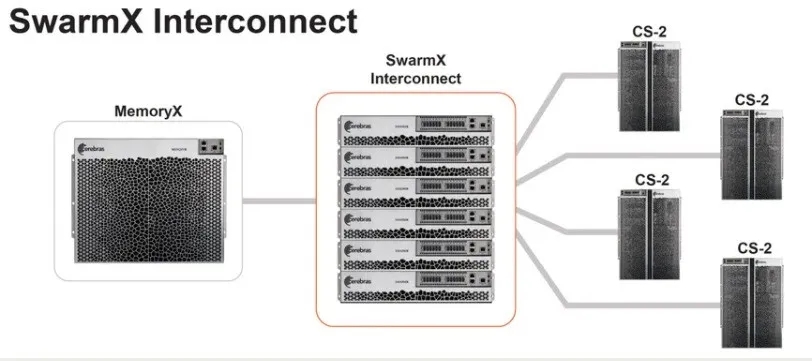

Cerebras' MemoryX system delivers and manipulates weights for neural network training in the CS-2. The SwarmX network allows up to 192 CS-2s to work together on the same network.CEREBRAS

Feldman说:“我们终于解决了最紧迫的问题之一:如何使构建集群变得简单。”

因为一个WSE2可以保存一个网络中的所有激活,Cerebras可以想出一个方案,使计算机数量加倍确实可以使训练速度加倍。首先,代表神经网络的一整套激活被复制到每个CS-2(为了简单起见,让我们假设您只有两台AI计算机),然后相同的一组权重流到两台计算机。但是训练数据被分成两半,一半的数据发送到每个CS-2。使用一半的数据,计算梯度需要一半的时间。每个CS-2都会产生不同的梯度,但这些可以结合起来更新MemoryX中的权重。然后,新的重量流传输到CS-2,与之前一样,该过程重复进行,直到获得准确的网络,在这种情况下,只需一台计算机所需时间的一半。

Neural network weights flow to CS-2 computers linked by the SwarmX system. Training data is divided up and delivered to the CS-2s, which compute the backpropagation gradients that are combined and delivered to MemoryX CEREBRAS

Hot Chips报道的最后一项创新被称为Selectable Sparsity:一种动态稀疏选择技术。这是一种在不影响网络准确性的情况下减少训练中涉及的参数数量的方法。稀疏性在人工智能中是一个巨大的研究领域,但对于CS-2来说,它涉及的很多方面都是从不乘以零的。

Cerebras首席执行官兼联合创始人Andrew Feldman表示,这推动了行业的发展。根据该公司的说法,这四项创新的结合可帮助Cerebras计算机保持在神经网络的顶端,为研究和见解开辟广阔的新途径。

- 上一篇:人工智能新图景:这里比想象更“无限” 2021/9/14

- 下一篇:我心向党|热烈庆祝协会党支部正式成立 2021/9/9